6 عامل مؤثر بر نتیجه نهایی در بازی رولت وجود دارد:

فروشنده توپ را از موقعیت قبلی انتخاب می کند ، چرخ را چرخان می کند تا در یک جهت شتاب بگیرد و توپ را در جهت مخالف چرخاند.

جهت مرحله قبل بین جهت عقربه های ساعت و خلاف جهت عقربه های ساعت تغییر خواهد کرد.

تبدیل قدرت فروشنده.

برخورد جیب توپ.

آیا چرخ کج است.

نفوذ انسان از یک فروشنده. ممکن است نماینده پس از چند دور تغییر جهت را فراموش کند ، یا به یک فروشنده متفاوت تغییر دهد و منجر به توزیع متفاوت شود.من با ارائه یک منبع باز و بخشی از ارائه کار زیر شروع کردم. سه عامل اول در کد را می توان با تنظیم جهت ها و دو قدرت تصادفی (چرخ نخ ریسی و چرخاندن توپ) در یک محدوده مناسب شبیه سازی کرد. فاکتورهای پنجم و ششم را می توان نادیده گرفت ، اگر فرض کنیم با ماشین رولت بازی می کنیم (که شما فقط این کار را کردید). فاکتور 4 پیچیده تر است و برای بهبود در آینده باقی مانده است.

بعد از تنظیم محیط ، 100000 رکورد در حال اجرا را اجرا کردم ، 90،000 رکورد اول تمرین و مابقی را برای آزمون تقسیم کردم در زیر نمودار میله ای برای تعداد و رنگ گروه تمرین و گروه آزمون قرار دارد.

همانطور که مشاهده می کنید ، داده های ما بعد از اینکه محدودیت هایی را تعیین کردیم ، هنوز توزیع یکنواخت دارند ، بیایید ببینیم که آیا می توانیم یک عامل RL را برای کسب درآمد در محیط شبیه سازی شده خود آموزش دهیم.

بازی رولت چیست ؟ الگوریتم و روش آزمایش

برای تخمین عملکرد استراتژی های مختلف ، رکورد را به دورهای مختلف تقسیم کردم. برای هر دور با 100 رکورد ، از 20 رکورد برتر برای نظارت استفاده می شود و نماینده با 80 رکورد باقی مانده بازی می کند. 900 دور تمرین و 100 دوره تست برگزار خواهد شد و دلیل اینکه من 20 سال به آن توجه کردم این است که کازینوها 20 شماره آخر را بطور پیش فرض نشان می دهند.

یادگیری Q یکی از رایج ترین الگوریتم های RL است. "س" در یادگیری Q به کیفیت اشاره دارد. یادگیری Q مبتنی بر ایده ارزیابی کیفیت اقدامات انجام شده برای انتقال به یک وضعیت است. ما یک جدول q ایجاد می کنیم تا مقدار q را برای انجام اقدامات در مورد s ایجاد کنیم. مقدار q در ابتدا تنظیم شده است به صفر ، و در حالی که ما متوجه پاداش r از اقدامات مختلف می شویم ، آنها با استفاده از معادله بلمن به روز می شوند:

حالا که منطقی است ، آیا می توانیم مستقیماً از پرونده خود استفاده کنیم؟

خوب ، نه خیلی سریع ، یک مشکل کوچک وجود دارد که باید حل شود ...

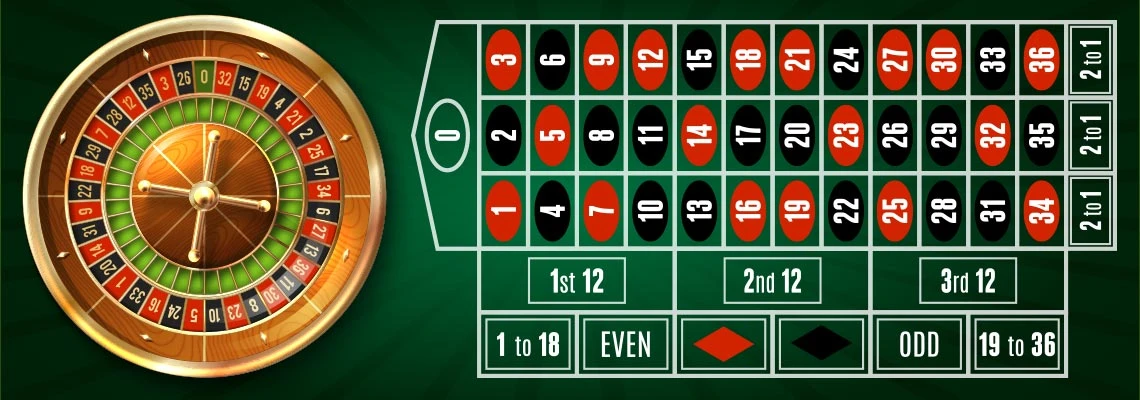

به یاد داشته باشید که ما 20 رقم آخر را به عنوان یک ساعت مچی گرفتیم؟ برای رولت به سبک اروپایی 37 عدد چرخ وجود دارد و در نتیجه فضای کشور ما دارای شرایط 37 درجه خواهد بود.

مشکل چیه؟ ممکن است از FP32 برای ذخیره مقدار q استفاده کنیم ، زیرا فضای حالت 37²⁰ است ، اندازه جدول q در مورد (تعداد اقدامات) x 10³² بایت خواهد بود. این بیش از حداکثر ظرفیت هر مرکز داده در جهان است ، لازم به ذکر نیست که ما برای آموزش نمایندگان نیز به همان میزان داده نیاز داریم.

اینجاست که یادگیری عمیق به وجود می آید. می توانیم از شبکه عصبی عمیق برای جایگزینی جدول q استفاده کنیم ، که روح یادگیری عمیق است.

در یادگیری عمیق Q ، شبکه q-q مقدار q را برای اقدامات پیش بینی می کند ، و اقدام بعدی با حداکثر خروجی q-grid به جای جدول جستجو تعیین می شود. برای تنظیم وزن شبکه عصبی از عملکرد برگشتی و انتشار استفاده می کند.

با بازگشت به تجربه ما ، سه استراتژی را برای ارزیابی انتخاب کردم.

مستقیم: هر عدد از جمله 0 را ضبط کنید

گروه های 1 به 1: تعیین کنید که عملکرد 1 تا 1 است (تک ، یکدست ، قرمز ، سیاه ، 1 تا 18 ، 19 تا 36)

ترکیبات 2 به 1: تعیین میزان عملکرد 2 تا 1 (ستون اول ، ستون دوم ، ستون سوم ، دهم اول ، دهم دوم ، دهم سوم)

فروشنده براساس استراتژی فعلی مورد استفاده ، محلی برای شرط بندی انتخاب می کند. همچنین گزینه ای برای تصویب آن وجود دارد زیرا در صورتی که فقط بتوانید

شرایط خاصی را تحت نظر داشته باشید و منتظر بمانید ، معقول تر می شود.

برای هر دور از بازی هزار دلار پول بذر وجود دارد. شرط بندی 50 دلار است. این تور هنگامی به پایان می رسد که نماینده 2000 دلار درآمد داشته باشد یا پولش تمام شود. شما همچنین پس از 80 مرحله به پایان خواهید رسید. این آزمایش با هدف مقایسه کل سود سودآور ، درصد برنده و تعداد مراحل دستیابی به شرایط نهایی توسط سه عامل بر اساس یک استراتژی متفاوت انجام شده است.